デモ

test.1

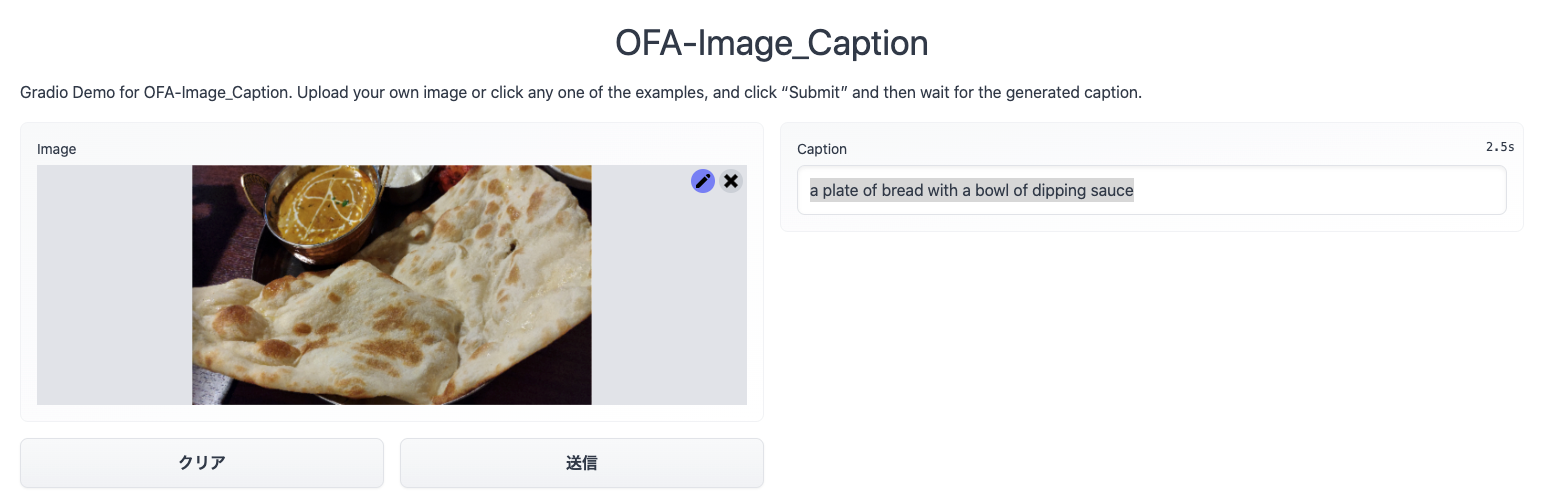

ありがたいことにhugging faceで推論を試す環境が出来上がっていました

OFA-Image_Caption - a Hugging Face Space by OFA-Sys

Discover amazing ML apps made by the community

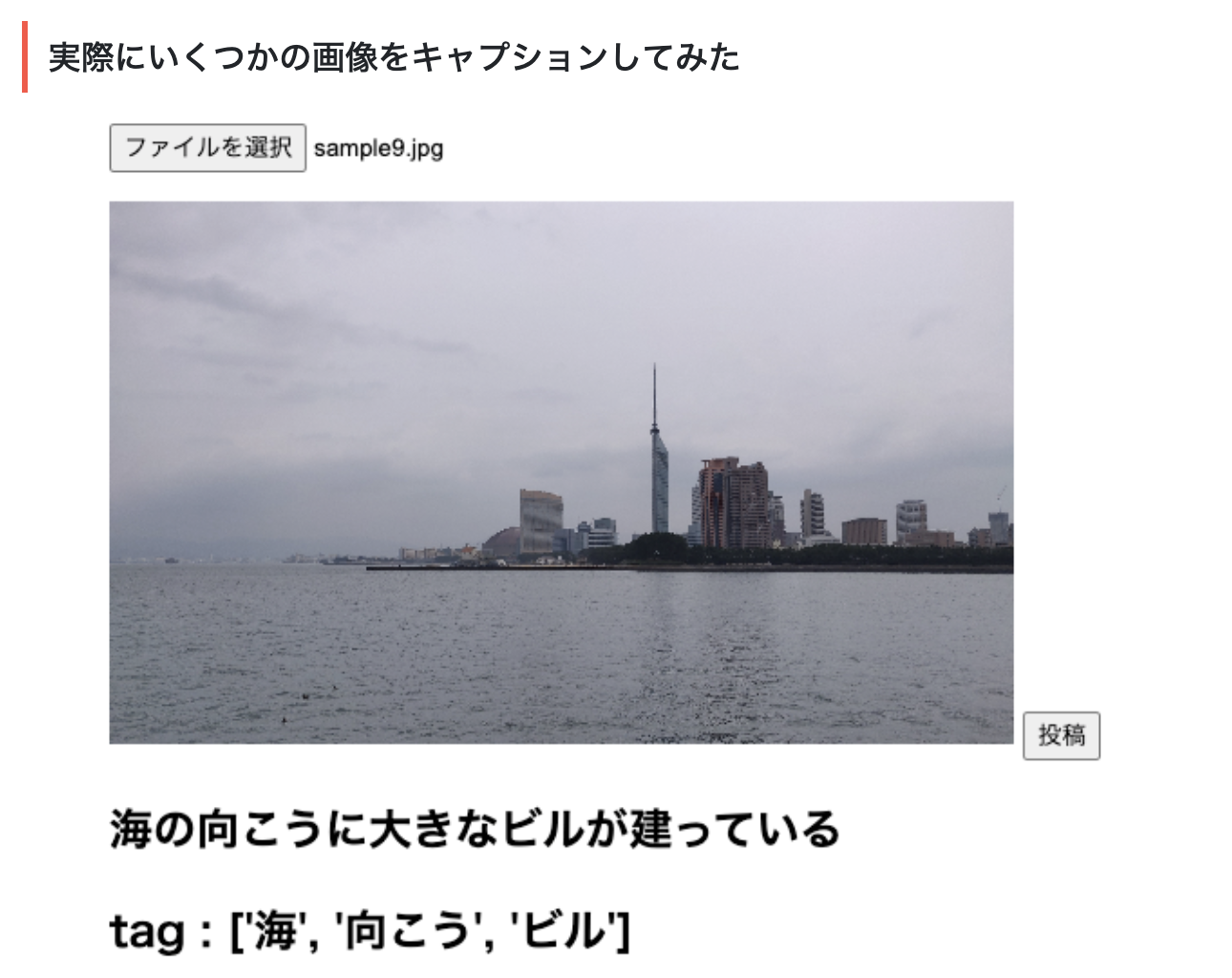

まずは、この画像を試してみます

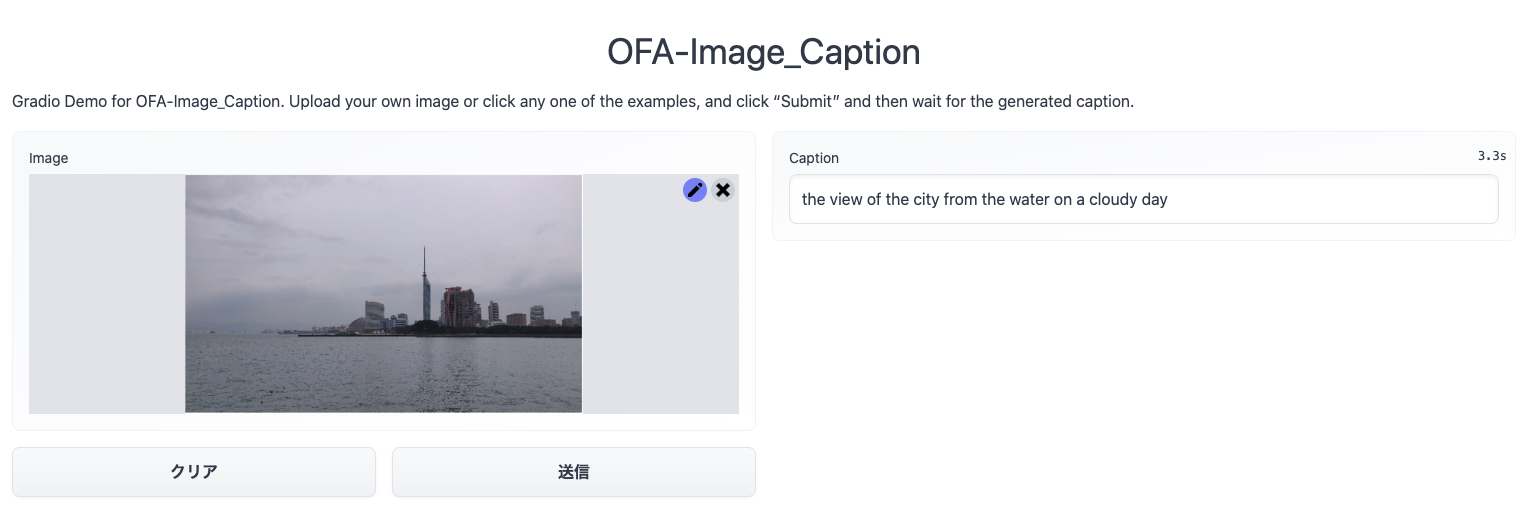

OFAの出力「the view of the city from the water on a cloudy day」

google 翻訳結果 「曇りの日の水からの街の眺め」

文面から見るに、OFAは海であるとは判断しなかったところは相違点の一つですね。

また天気が曇りであることを文章に含めていることも相違点ですね。

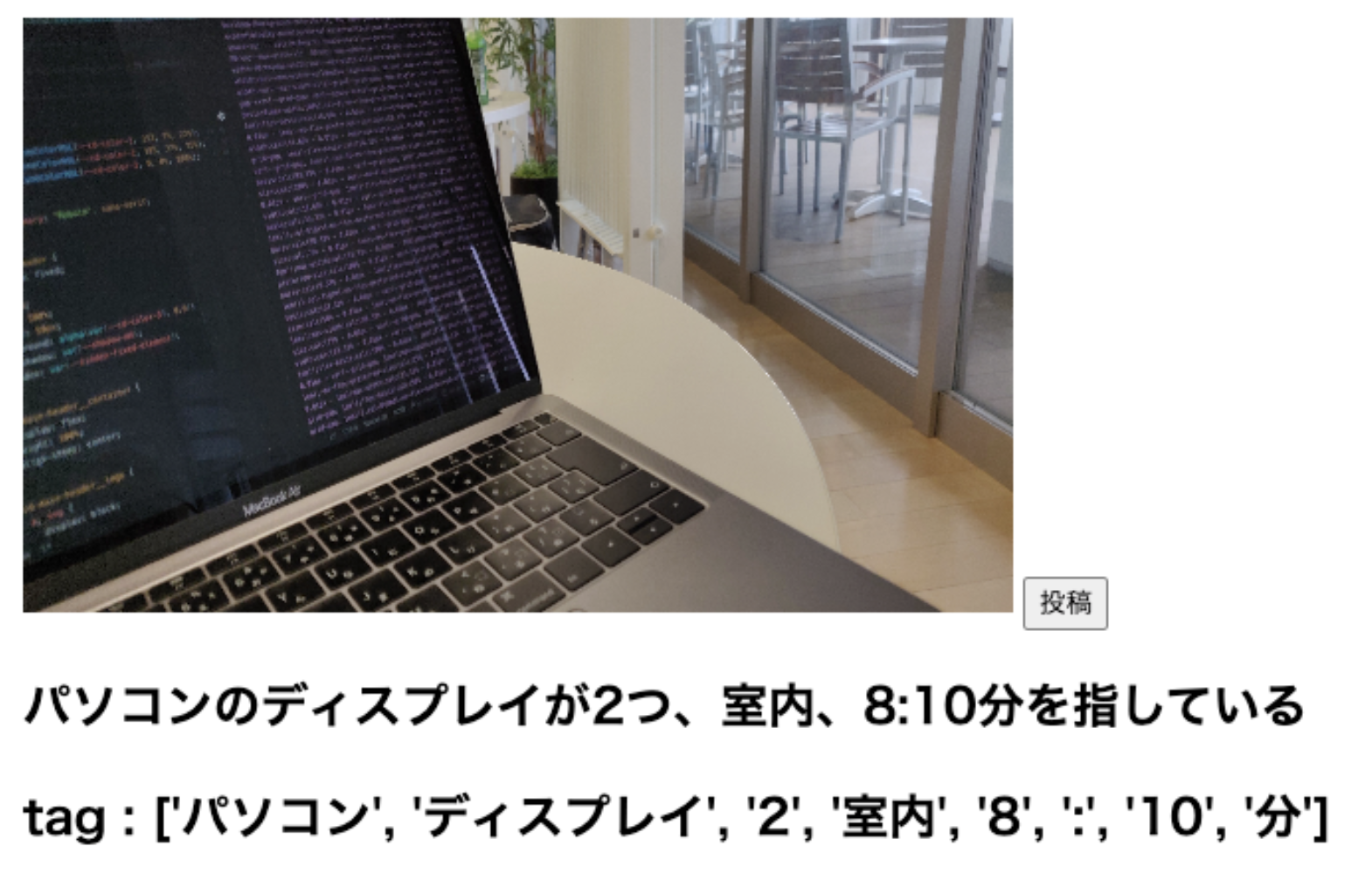

test.2

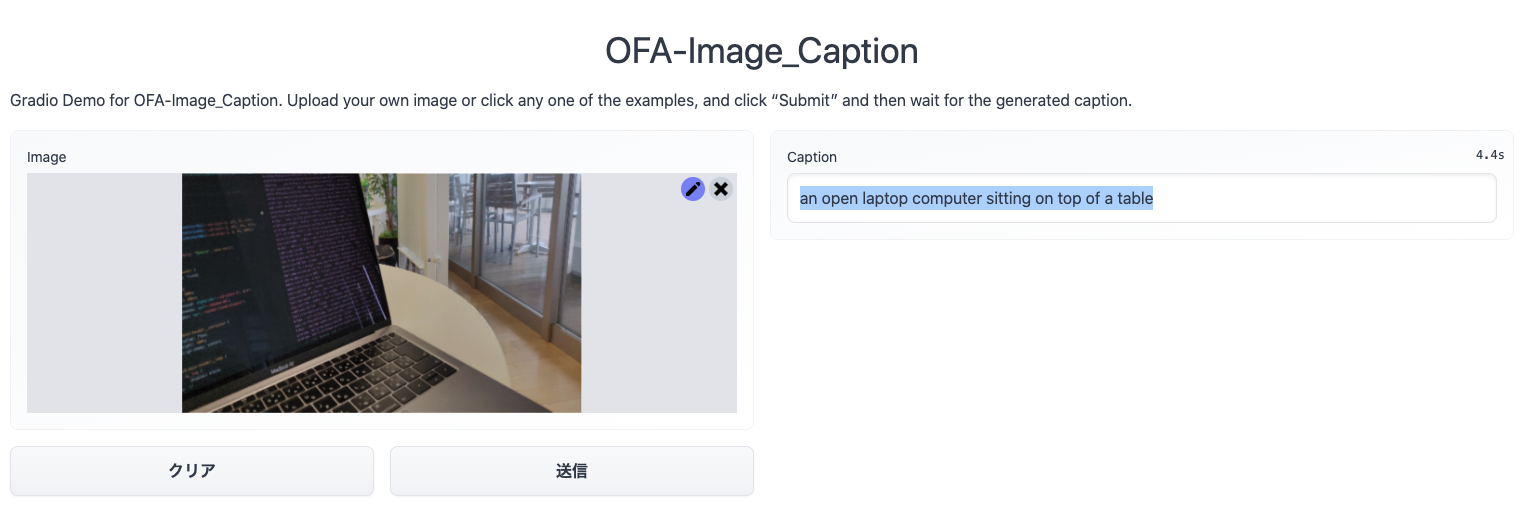

OFAの出力「an open laptop computer sitting on top of a table」

google 翻訳結果 「テーブルの上に座っているオープンラップトップコンピュータ」

これはOFAの方がより正確に状況を把握できている感じがしますね

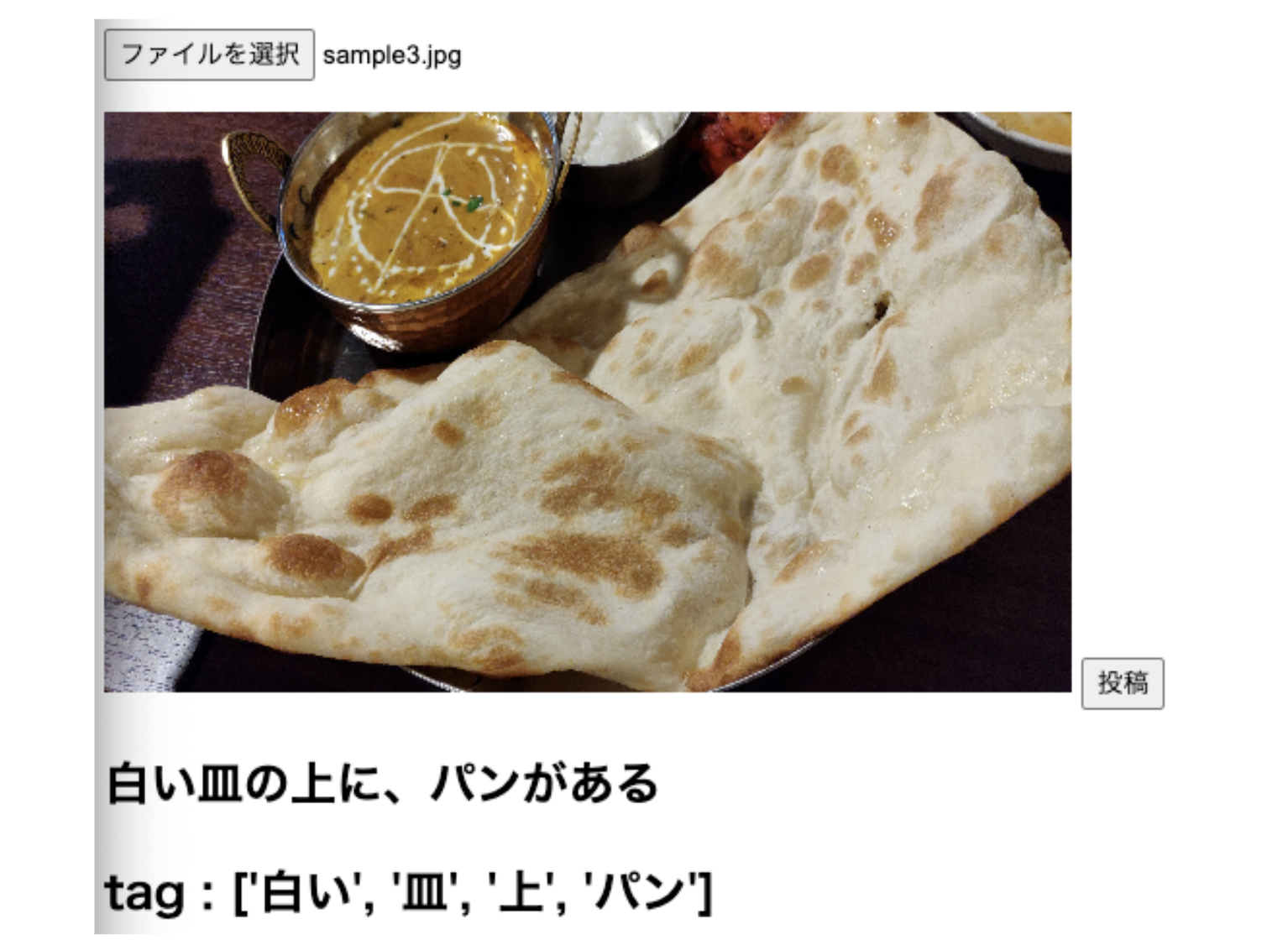

test.3

OFAの出力「a plate of bread with a bowl of dipping sauce」

google 翻訳結果 「パンのプレートとディップソースのボウル」

どちらもナンのことをパンと呼んでいるのが興味深いですね。

おそらくデータセットにナンが無いのでしょう。

感想

今回は、Image Captioningの現在SoTAのOFAを試して、過去にImage Captioningを試した時の結果と比較してみました。

若干条件に差はあるものの、OFAは明らかに関係の無い言葉は出てきにくいのかなという印象がありますね。

どんな秘密が中にあるのか、この後論文を読んでみようと思います

Ryu Ishibashi

機械学習/Vue/React/Laravelとかやってます